Causal Representation-Based Domain Generalization on Gaze Estimation

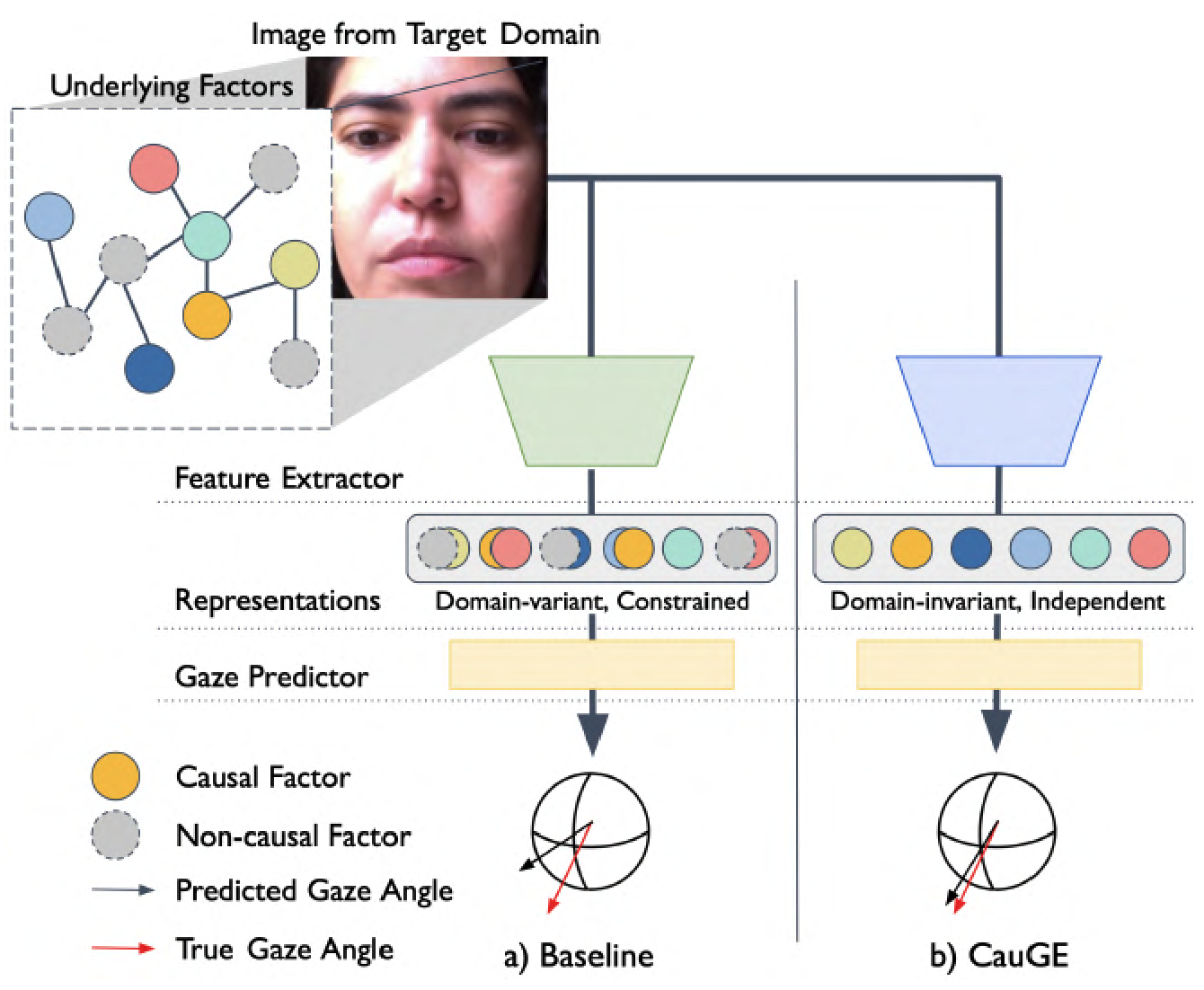

The availability of extensive datasets containing gaze information for each subject has significantly enhanced gaze estimation accuracy. However, the discrepancy between domains severely affects a model’s performance explicitly trained for a particular domain. In this paper, we propose the Causal Representation-Based Domain Generalization on Gaze Estimation (CauGE) framework designed based on the general principle of causal mechanisms, which is consistent with the domain difference. We employ an adversarial training manner and an additional penalizing term to extract domain-invariant features. After extracting features, we position the attention layer to make features sufficient for inferring the actual gaze. By leveraging these modules, CauGE ensures that the neural networks learn from representations that meet the causal mechanisms’ general principles. By this, CauGE generalizes across domains by extracting domain-invariant features, and spurious correlations cannot influence the model. Our method achieves state-of-the-art performance in the domain generalization on gaze estimation benchmark.

Problem:: 시선 추정 모델의 도메인 간 성능 저하 / 데이터셋 간 분포 차이 (appearance, illumination 등) / 눈 영역 의존성으로 인한 spurious correlation 취약성 / Domain Adaptation 방법들의 실용성 한계 (타겟 데이터 필요)

Solution:: Causal Mechanism 원칙 기반 domain-invariant representation 학습 / AugMix로 도메인 이동 시뮬레이션하여 causal/non-causal factors 분리 / Adversarial training으로 도메인 불변 특징 추출 / Factorization loss로 representation 독립성 보장 / Attention layer로 중요 causal factors 가중치 부여

Novelty:: 시선 추정 분야 최초 causality 개념 도입 / Causal mechanisms의 4가지 원칙 (CCP, Stability, Modularity, Causal Heterogeneity) 통합 적용 / Domain Generalization에서 SOTA 성능 (평균 6.92°) / 타겟 데이터 없이 cross-dataset generalization 달성

Note:: 1-Stage cross-dataset 실험에서 가장 단순하면서 효과적인 듯 / Causal Mechanism 적용 동기는 이해가 가는데, Factorization Loss만으로 달성 가능한지는 의문스러움 → 관련 논문을 봐야할 듯

Summary

Motivation

문제제기

- 도메인 간 성능 저하 문제: 한 도메인에서 훈련된 시선 추정 모델이 다른 도메인에서 심각한 성능 저하를 보임

- 성능 저하의 두 가지 주요 원인:

- 분포 차이 (Distribution Gap): 데이터셋 간 subject appearance, image quality, shooting angle, illumination 등의 차이

- Spurious Correlation 취약성: 시선 추정이 얼굴 이미지의 작은 부분인 눈 영역에 크게 의존하여 non-causal factor에 쉽게 영향받음

기존 방법의 한계

- Domain Adaptation 방법들은 타겟 데이터셋 샘플과 추가 최적화 과정이 필요하여 실제 시나리오에서 적용하기 어려움

- 기존 Domain Generalization 방법들도 통계적 의존성만으로는 underlying causal mechanism을 충분히 설명하지 못해 도메인 간 불안정성 존재

Method

CauGE Framework 개요

- 핵심 아이디어: Causal Mechanism의 일반 원칙을 만족하는 representation을 학습하여 도메인 불변 특징을 추출

- Causal Factors (S)와 Non-Causal Factors (U)의 분리를 통해 spurious correlation의 영향을 제거

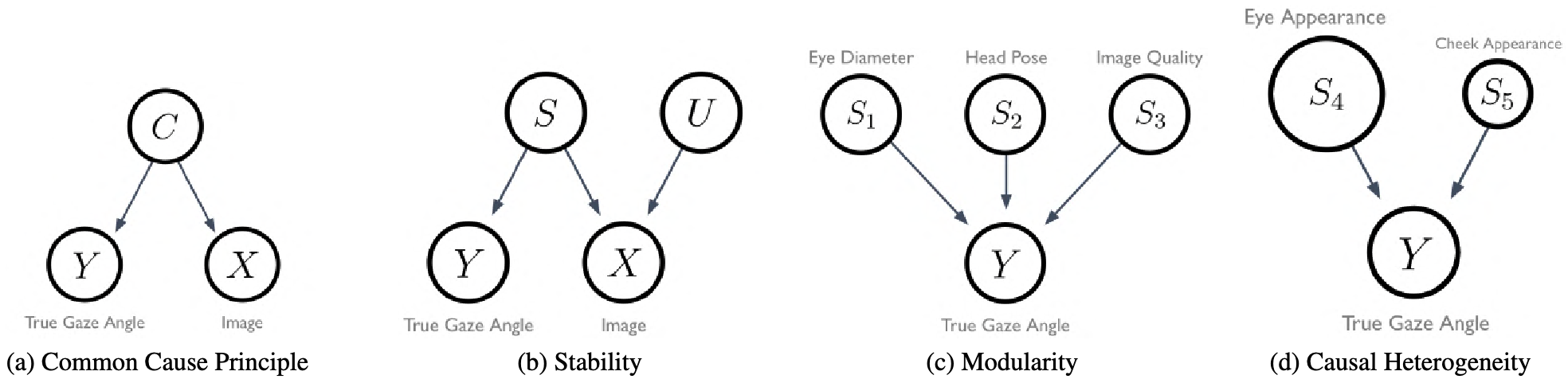

Causal Mechanism의 일반 원칙 적용

1. Common Cause Principle (CCP)

- Image (X)와 True Gaze Angle (Y)이 상관관계가 있다면, 둘 사이에 공통 원인 C가 존재해야 함

- C를 찾아 X와 Y 사이의 spurious correlation을 제거하는 것이 목표

2. Stability

- "S causes Y"라는 인과 관계는 다양한 조건에서도 불변해야 함

- 예: 조명(U)이 변해도 eyeball rotation (S)과 gaze angle (Y)의 관계는 변하지 않음

- 수식:

3. Modularity

- 각 causal mechanism은 독립적으로 작동

- 한 mechanism의 변화가 다른 mechanism에 직접적인 영향을 주지 않음

- 예: eye diameter (S₁), head pose (S₂), image quality (S₃)가 Y에 영향을 주는 mechanism은 서로 독립적

4. Causal Heterogeneity

- 모든 causal factor가 동등하지 않음 - 일부는 더 중요한 역할을 함

- 예: eye appearance (S₄)가 cheek appearance (S₅)보다 시선 추정에 더 중요

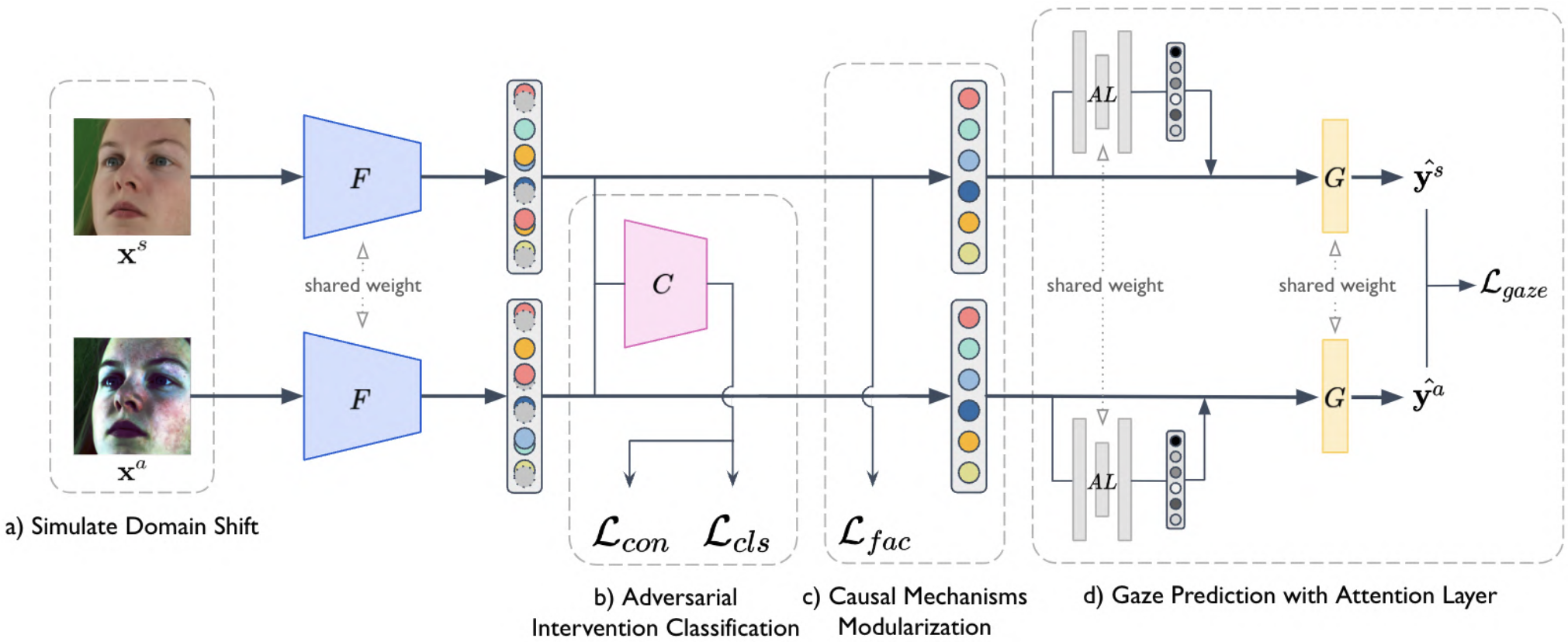

구체적인 구현 방법

1. Simulating Domain Shift

- AugMix 사용: 도메인 이동을 시뮬레이션하여 S와 U를 분리

- ShearX, ShearY, translate, rotate 연산은 제외하여 gaze angle 변화 방지

- Original image (

)와 augmented image ( )를 생성

2. Adversarial Intervention Classification

- Feature Extractor (F)가 도메인 불변 특징을 추출하도록 강제

- Intervention Classifier (C): 이미지가 원본인지 augmented인지 구분

- Adversarial training: F는 C를 혼란시키도록, C는 정확히 구분하도록 학습

- Loss functions:

(inverted label 사용)

3. Causal Mechanisms Modularization

- Factorization Loss로 representation의 독립성 보장

- Correlation matrix M을 사용:

- Loss:

4. Gaze Prediction with Attention Layer

- SE-Net의 soft attention 사용하여 causal factor들에 가중치 부여

- Squeeze: Global average pooling으로 channel-wise statistics 생성

- Excitation: Sigmoid function으로 0-1 범위의 channel-wise attention map 생성

- Gaze loss:

Method 검증

실험 설정

- 소스 도메인: Gaze360 (

), ETH-XGaze ( ) - 타겟 도메인: MPIIFaceGaze (

), EYEDIAP ( ) - 4개의 cross-dataset 평가:

, , ,

정량적 성능 비교

- CauGE가 모든 설정에서 SOTA 성능 달성

- 평균 angular error: 6.92° (vs Baseline 13.36°)

- PureGaze 대비 1.37° 개선, GcFE 대비 0.71° 개선

- 특히 DG→DM에서 가장 큰 성능 향상 (6.36° vs GcFE 7.55°)

Ablation Study

- 모든 구성 요소가 성능 향상에 기여:

- Intervention confusion loss만: 7.56° → 도메인 불변성에 기여

- Factorization loss만: 7.48° → 독립적 특징 추출에 기여

- Attention layer만: 7.54° → 중요 특징 강조에 기여

- 전체 조합 시 최고 성능: 6.92°

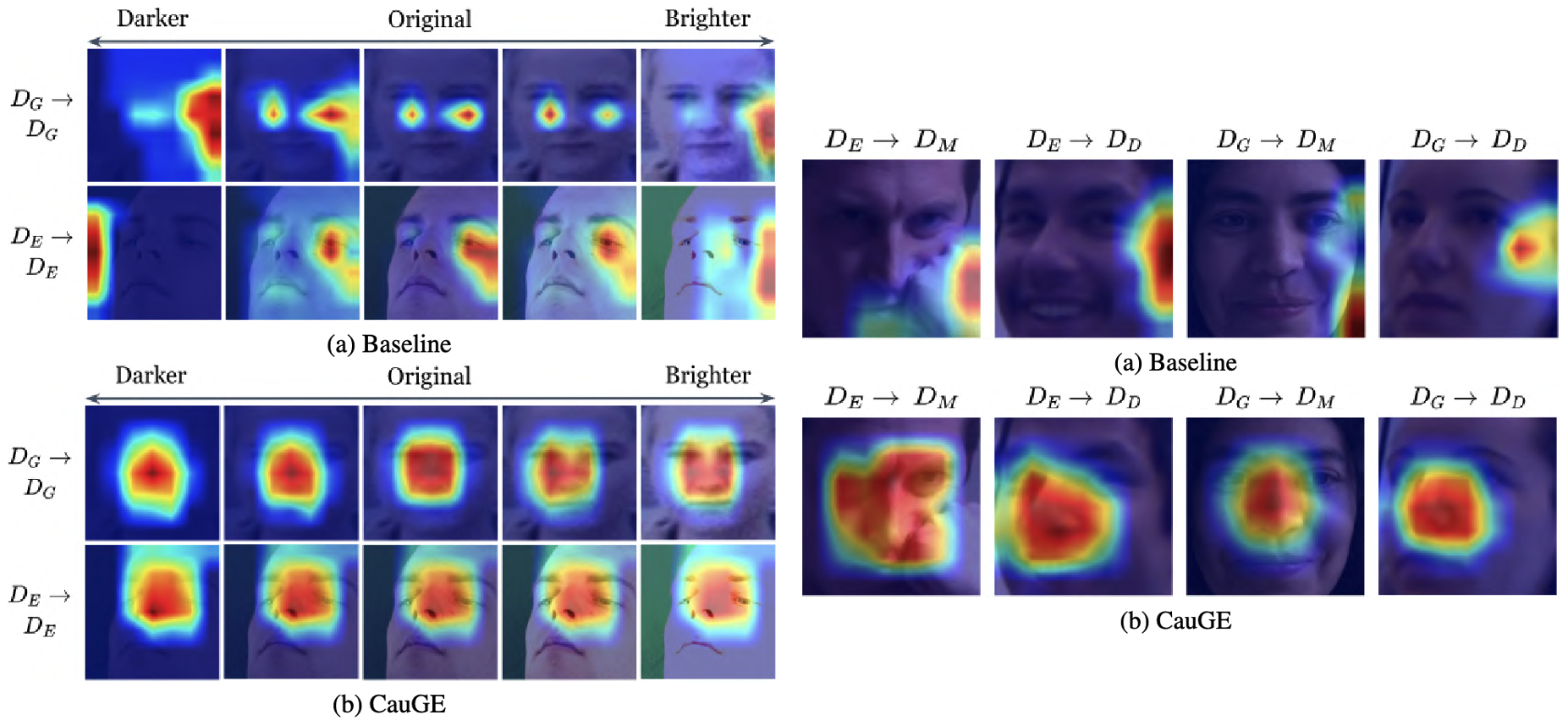

정성적 분석

Class Activation Map 시각화

- Baseline: illumination 변화에 따라 activation pattern이 inconsistent

- CauGE: illumination 변화에도 consistent한 activation pattern 유지 → 도메인 불변 특징 추출 확인

- CauGE는 얼굴 영역에 집중하는 반면, Baseline은 non-face region에도 의존

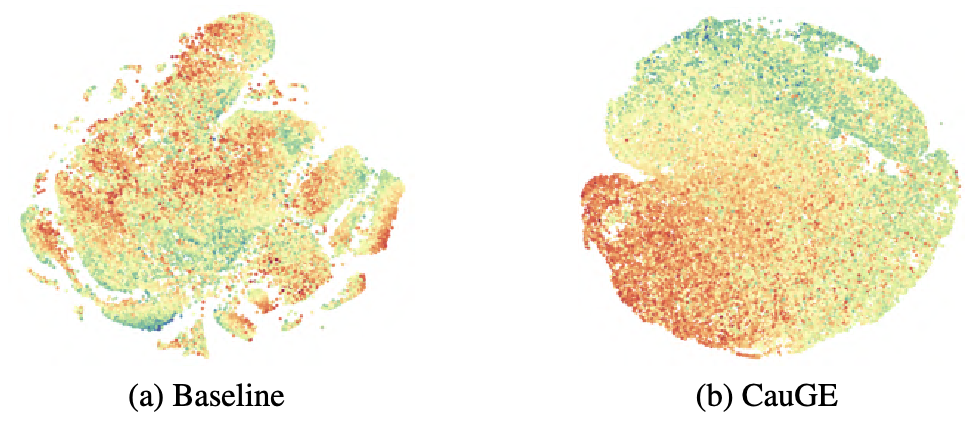

t-SNE Visualization

- Baseline: 시선 방향과 무관한 clustering, domain shift에 취약

- CauGE: 시선 방향에 따라 명확한 clustering, 도메인에 불변 → causal factor 추출 성공

추가 실험

Domain Shift Simulation 비교

- AugMix vs Fourier Transform 기반 augmentation 비교

- AugMix 사용 시 더 나은 성능 (6.92° vs 8.06°) → gaze 정보 손실 없이 data 다양성 확보

Attention Layer 효과성

- Adversarial Mask Module (AMM)과 비교

- Attention Layer가 더 효과적 (6.92° vs 11.56°) → specific factor weighting이 중요