Erasing Concepts from Diffusion Models

Motivated by concerns that large-scale diffusion models can produce undesirable output such as sexually explicit content or copyrighted artistic styles, we study erasure of specific concepts from diffusion model weights. We propose a fine-tuning method that can erase a visual concept from a pre-trained diffusion model, given only the name of the style and using negative guidance as a teacher. We benchmark our method against previous approaches that remove sexually explicit content and demonstrate its effectiveness, performing on par with Safe Latent Diffusion and censored training. To evaluate artistic style removal, we conduct experiments erasing five modern artists from the network and conduct a user study to assess the human perception of the removed styles. Unlike previous methods, our approach can remove concepts from a diffusion model permanently rather than modifying the output at the inference time, so it cannot be circumvented even if a user has access to model weights. Our code, data, and results are available at erasing.baulab.info.

Problem:: 대규모 디퓨전 모델이 원치 않는 콘텐츠(성인물, 저작권 있는 아티스트 스타일)를 생성하는 문제 / 기존 방식(데이터셋 필터링, 추론 시간 검열)은 비용이 많이 들거나 쉽게 우회 가능

Solution:: 텍스트 설명만을 사용하여 모델 가중치에서 특정 개념을 영구적으로 제거하는 Fine-tuning 방법 제안 / 부정적 가이던스를 통한 자기 지도 학습으로 추가 데이터 없이 개념 제거

Novelty:: 모델 가중치 수준에서 직접 개념을 제거하여 우회 불가능한 안전장치 구현 / Cross-attention과 Self-attention 파라미터의 선택적 조정을 통한 맞춤형 개념 제거 방식

Note:: 근데 FT를 한다는거 자체가 이미 추가 연산량이 소모되는 게 아닌가?

Summary

Motivation

- 최근 텍스트-이미지 생성 모델들은 막대한 인터넷 데이터셋으로 학습되어 놀라운 이미지 품질과 무한한 생성 능력 보유

- 그러나 학습 데이터에서 습득한 원치 않는 개념들도 함께 학습됨

- 성인물 콘텐츠와 같은 부적절한 내용

- 저작권이 있는 아티스트 스타일

- 기존 접근법의 한계

- 데이터셋 필터링: 대규모 모델 재학습에 막대한 비용 소요(SD 2.0의 경우 150,000 GPU-시간)

- 추론 시간 필터링/가이딩: 오픈 소스 환경에서 쉽게 우회 가능(코드와 가중치 공개)

- Safe Latent Diffusion과 같은 방법은 추론 시간에 회피 가능

- 이러한 문제를 해결하기 위해 모델 가중치에서 직접 개념을 제거하는 방법 필요

Method

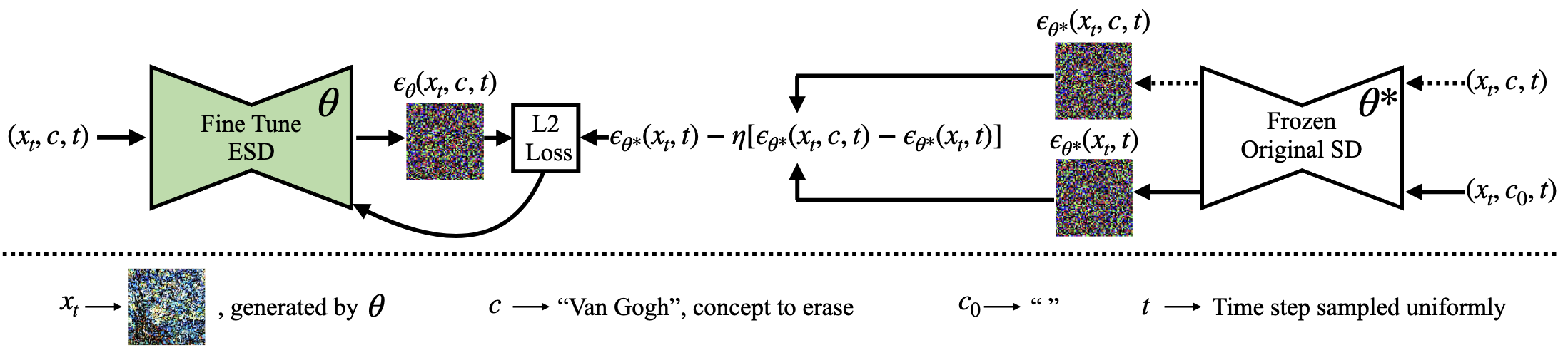

- ESD(Erased Stable Diffusion): 디퓨전 모델에서 특정 시각적 개념을 지우는 Fine-tuning 방법

- 제거하려는 개념에 대한 텍스트 설명만을 사용하고 추가 데이터 없이 모델 가중치 수정

- 학습 과정:

- 원본 모델

는 동결시키고 새로운 파라미터 를 학습 - 개념

에 대한 조건부 이미지 를 샘플링 - 동결된 모델

로 조건부/비조건부 노이즈 예측 수행 - 부정적 가이던스 적용:

- 새 모델

를 이 목표를 향해 조정

- 원본 모델

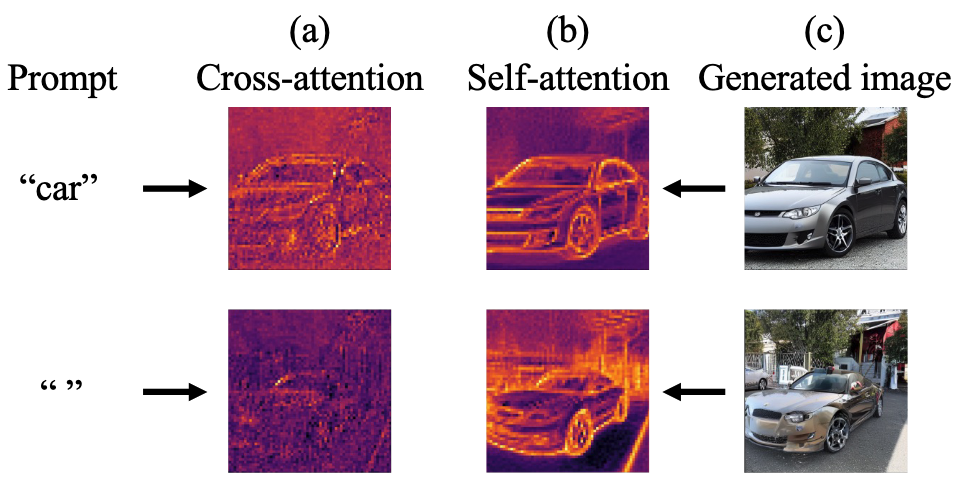

Cross-Attention은 프롬프트에 명시된 Feature, Self-Attention은 프롬프트와 무관하게 알고있는 Feature에 관여

- 파라미터 선택의 중요성

- ESD-x: Cross-attention 파라미터만 수정 (프롬프트에 명시된 경우에만 개념 제거)

- ESD-u: Self-attention 등 Non-cross-attention 파라미터 수정 (프롬프트와 무관하게 전역적 개념 제거)

- ESD-x는 아티스트 스타일 제거에 적합, ESD-u는 NSFW 콘텐츠나 객체 제거에 적합

Method 검증

예술 스타일 제거

- 실험 설정: 5명의 현대 아티스트(Kelly McKernan, Thomas Kinkade 등) 스타일 제거 실험

- 원본/편집 모델 간 스타일 비교를 위한 사용자 연구 수행

- ESD-x 방법이 타 스타일 간섭 최소화(평균 간섭 10% 이하)하면서 목표 스타일 효과적 제거

- 사용자 연구 결과 ESD-x가 목표 스타일 제거에 가장 효과적(평균 평점 1.12/5)으로 평가됨 → [5-notes/PaperReview/schramowski2023safe|SLD]와 SD-Neg-Prompt(2.22/5)보다 우수한 성능

성인물 콘텐츠 제거

- 실험 설정: I2P 벤치마크 4,703개 프롬프트 사용

- ESD-u 방법이 노출된 신체 부위 이미지를 SD 1.4 대비 83% 감소

- 기존 SD 1.4에서 796개의 노출 이미지가 ESD-u 적용 후 134개로 감소

- SD 2.0(NSFW 필터링 데이터로 재학습)보다 더 효과적으로 NSFW 콘텐츠 제거

- COCO 30K 데이터셋에서 이미지 품질 측정 결과 FID 점수 13.68로 원본 SD(14.50)보다 우수함 → 이미지 품질 저하 없음

객체 제거

- 실험 설정: ImageNet에서 10개 클래스 제거

- 목표 클래스 분류 정확도 평균 78.2%에서 12.6%로 크게 감소 → 효과적인 개념 제거

- 다른 클래스에 대한 영향은 제한적(78.2%에서 63.2%로 감소)

- 일부 객체(church와 같은)는 제거가 더 어려움 → 완전히 제거되지 않고 핵심 요소(십자가)만 제거됨

메모리화된 이미지 제거

- 단일 아트워크(예: Starry Night) 제거 시 해당 아티스트의 전반적 스타일에 거의 영향 없음

- 여러 아트워크 동시 제거 시 다른 메모리화된 아트워크에도 영향 → 더 많은 아트워크 제거할수록 간섭 증가

가이던스 강도(

증가할수록 개념 제거 효과 증가하나 간섭도 증가 일 때 누드 92% 제거, 객체 인식 34% 저하 일 때 누드 88% 제거, 객체 인식 14% 저하 일 때 누드 83% 제거, 객체 인식 7% 저하

Limitation

- 일부 개념(church, parachute 등)은 완전히 제거되지 않고 주요 특징만 제거됨

- 강력한 개념 제거 설정(

높음)은 관련 없는 스타일이나 객체에도 간섭 발생 - 객체 클래스 제거 시 다른 클래스 성능도 일부 저하(78.2%→63.2%)